Echt oder Fake? Wie wir Bildern noch glauben können

Die Bevölkerung wird zunehmend mit synthetischen Bildern konfrontiert – und gleichzeitig wissen viele Menschen bis heute kaum, was Deepfakes eigentlich sind. Daniel Bendahan Bitton, Kommunikationswissenschaftler an der Universität Leipzig, untersucht genau diesen Widerspruch. Sein Forschungsteam hat bundesweit repräsentative Befragungen durchgeführt – und die Ergebnisse zeigen eine Mischung aus Unwissen, Unsicherheit und wachsendem Misstrauen.

2022 wussten noch 67 Prozent der Deutschen nicht, was Deepfakes sind. Auch heute kennen fast 45 Prozent den Begriff nicht. Ein technologisches Phänomen ist also in der breiten Gesellschaft angekommen – aber ohne dass Wissen und Kompetenzen im selben Tempo mitgewachsen wären. Aber die Folgen sind schon zu spüren. "Allein das Wissen darüber, dass Deepfakes existieren, verstärkt Medienzynismus und schmälert das Vertrauen in Online-Nachrichten", sagt der Kommunikationswissenschaftler.

Die Suche nach verlässlichen Prüfmethoden

Wie können wir uns also in dieser neuen Welt orientieren, in der das eigene Auge immer seltener das letzte Wort hat? Um diese Frage zu beantworten, lohnt der Blick auf die jüngste SPRIND Challenge, ausgetragen von der Bundesagentur für Sprunginnovationen. Die Motivation dahinter: Technologien zu entwickeln und zu fördern, die reale von synthetischen Bildern unterscheiden und mit der Deepfake-Entwicklung Schritt halten zu können.

In Leipzig traten sieben Teams gegeneinander an. In einem speziell erstellten Benchmark-Test – mit mehreren tausend von der Deutschen Presse-Agentur bereitgestellten echten und KI-generierten Fotos – zeigte sich schnell, wie schwierig diese Aufgabe ist. "Ich habe mir die Bilder natürlich auch angeschaut", sagt Jano Costard, bei SPRIND verantwortlich für die Challenge, "und ich wusste schlichtweg nicht, ob sie echt oder KI-generiert sind."

Wie eine junge Firma die Erkennung neu denkt

Die Firma Itsreal.media, gegründet von Christoph Behl, setzte sich in diesem Wettbewerb gegen die anderen Bewerber durch. Mit einer Trefferquote von 99,8 Prozent bei echten Bildern und 72 Prozent bei KI-Bildern war Itsreal.media klarer Spitzenreiter. Doch was macht ihre Technologie besser als andere?

Christoph Behl arbeitet seit vielen Jahren in der Filmbranche und hat sich intensiv mit visuellen Mustern beschäftigt. Seine Deepfake-Erkennung basiert auf einem Mix aus menschlicher Intuition und maschineller Analyse auf vielen verschiedenen Ebenen. Fast immer geht es dabei um wiederkehrende Muster bei KI-Bildern. Um ein recht offensichtliches zu nennen: Haben Sie sich von der KI schon einmal das Bild einer analogen Uhr erstellen lassen?

Wenn nicht, tun Sie es bitte. Die Wahrscheinlichkeit ist sehr groß, dass es auf der Uhr etwa 10 nach 10 sein wird. KI-Modelle haben das offenbar anhand von Werbebildern und sogenannten Stock-Fotos so "gelernt", und die meisten tun sich noch immer sehr schwer damit, andere Uhrzeiten anzuzeigen. Das folgende Bild hat Nano Banana Pro auf den einfachen Prompt "Drei analoge Armbanduhren, die drei verschiedene Uhrzeiten anzeigen" generiert. Zusätzlich KI-verräterisch ist die Datumsanzeige "33" bei der mittleren Uhr.

Bildrechte: MDR Wissen (KI-generiert von Nano Banana Pro)

Bildrechte: MDR Wissen (KI-generiert von Nano Banana Pro)Aber nur selten sind KI-Bilder so vergleichsweise einfach zu erkennen. Moderne Generatoren produzieren nahezu makellose Bildoberflächen. "Wir schauen uns sehr viele Merkmale an", sagt Christoph Behl, "weil man heute keinen einzelnen Indikator mehr hat, der einem sicher sagt: Das ist KI."

Zu diesen Merkmalen gehören beispielsweise:

- Symmetrie (KI-Bilder setzen Personen auffällig häufig exakt mittig ins Bild)

- Augenformen und Physiognomie (KI tendiert zu standardisierten Formen, die sich subtil wiederholen)

- "Tote" Pixel (echte Kameras produzieren oft winzige Fehler, die als schwarze Pixel dargestellt werden, KI-Modelle nicht)

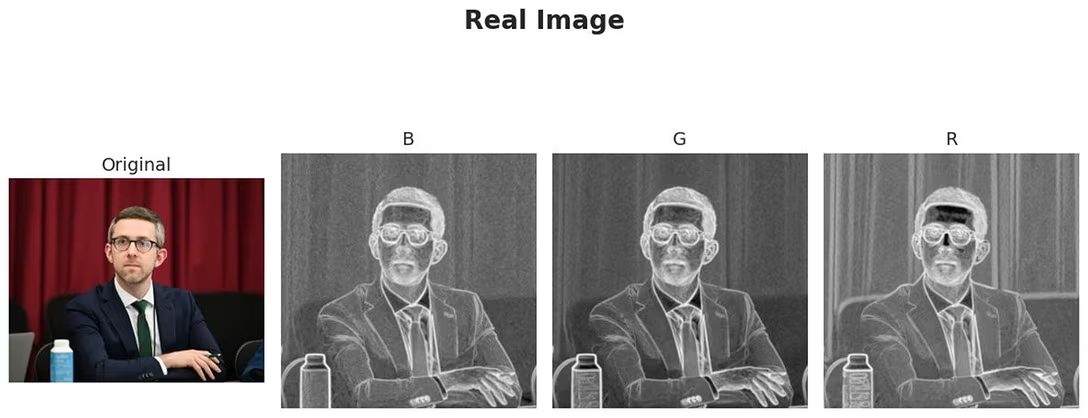

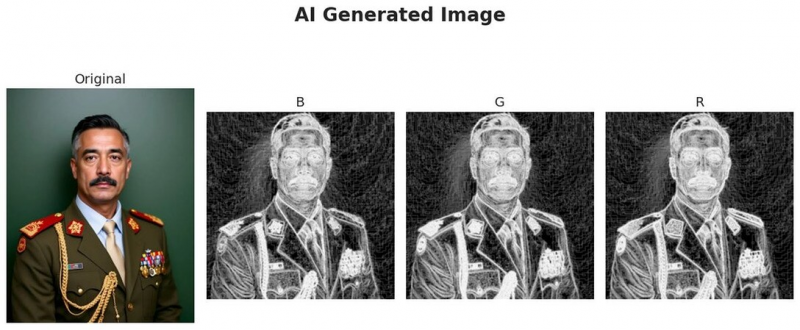

- Entropie-Muster, wo es um Unordnung oder Zufälligkeit von Pixeln im Bild geht. Mit einem eigenen Algorithmus kann Itsreal.media da Unterschiede zwischen Fotos und KI-Bildern deutlich machen.

Achten Sie auf die Hintergründe der Bilder. Beim echten Foto (oben) herrscht eine recht regelmäßige Pixelstruktur. Beim KI-generierten Bild (unten) ist die Entropie (Unordnung) groß.Bildrechte: Itsreal.media

Achten Sie auf die Hintergründe der Bilder. Beim echten Foto (oben) herrscht eine recht regelmäßige Pixelstruktur. Beim KI-generierten Bild (unten) ist die Entropie (Unordnung) groß.Bildrechte: Itsreal.media

Bildrechte: Itsreal.media

Bildrechte: Itsreal.mediaFake-Bilder bei Versicherungsbetrug und falschen Reklamationen

Itsreal.media hat nun den Vorteil, SPRIND-Challenge-Sieger zu sein. Das dürfte helfen, neue Geldgeber und auch Kunden zu finden. Wichtig und tatsächlich Geld wert ist, Fake-Bilder zu erkennen, zum Beispiel für Versicherungen und Versandhäuser. Dort haben Deepfake-Bilder von zerbrochenen Autoscheiben oder angeblich mangelhaften Produkten extrem zugenommen, erzählt Christoph Behl: "Ich habe gelesen, dass das um 3.000 Prozent gestiegen ist im letzten Jahr."

Aber Behls Firma stellt auch ein Zertifizierungssystem bereit, mit dem Internetseiten-Betreiber ihre gesamten Fotos überprüfen lassen können. Eine Zertifizierung über 100 Prozent Echtheit ohne KI schafft dann natürlich Vertrauen bei den Benutzern.

Wettlauf gegen die KI und für Vertrauen

Aber natürlich könnte sich ein Wettlauf entwickeln, bei dem die KI immer einen Schritt voraus ist. "Ja, man muss immer nachlegen, das ist ein Katz-und-Maus-Spiel", sagt Christoph Behl. Kaum kommt eine neue Modellversion zur Bildgenerierung auf den Markt, müssen auch die Erkennugssysteme neu angelernt werden. Andererseits glaubt Behl, dass sich der Markt in nächster Zeit beruhigen und sogar ausdünnen wird. "Es werden nicht alle überleben", sagt er, "ich denke, da werden sich wenige Modelle durchsetzen." Das mache es auch einfacher für seine Firma. "wenn man nur mit drei, vier Modellen arbeiten kann und nicht mit 20, wie wir das im Moment tun."

Neben technischer Erkennung wird aber wohl Vertrauen das zentrale Thema der Zukunft sein, wenn es um audiovisuelle Inhalte geht, gerade für Medienunternehmen. "Journalismus kann sich wieder als vertrauenswürdige Quelle positionieren, indem er Inhalte faktengeprüft und deepfake-geprüft bereitstellt", sagt Kommunikationswissenschaftler Daniel Bendahan Bitton.

Und was kann jeder einzelne tun? Es wird kaum mehr genügen, in Videos auf Mimik und Gestik eines Menschen zu achten, um typische KI-Fehler zu erkennen. Die Zeit dürfte vorbei sein, meint Bendahan Bitton. "Stattdessen rückt mehr die Frage nach der Authentizität und Plausibilität in den Vordergrund", sagt er. Um einschätzen zu können, ob das wirklich plausibel ist, was da zu sehen oder hören ist, sei aber Hintergrundwissen nötig.

Ein nächster Schritt sei ein "privater" Fakten-Check, also eine eigene Recherche, ob das gesehene Bild oder Video vielleicht schon irgendwo als Fake identifiziert wurde. "Um diesen Schritt zu gehen, muss man sich aber erst einmal bewusst sein, dass Deepfakes existieren", sagt Bendahan Bitton.

Dessen bewusst sind sich aber wahrscheinlich noch zu wenige.

Haftungsausschluss: Das Urheberrecht dieses Artikels liegt bei seinem ursprünglichen Autor. Der Zweck dieses Artikels besteht in der erneuten Veröffentlichung zu ausschließlich Informationszwecken und stellt keine Anlageberatung dar. Sollten dennoch Verstöße vorliegen, nehmen Sie bitte umgehend Kontakt mit uns auf. Korrektur Oder wir werden Maßnahmen zur Löschung ergreifen. Danke